Kubernetes 生命周期管理与服务发现深度解析

引言

Kubernetes 作为领先的容器编排平台,其核心能力在于自动化应用的部署、扩展和管理。其中,精细化的 Pod 生命周期管理和健壮的服务发现机制是保障应用稳定、高可用的基石。本文将深入探讨 Kubernetes 在这两个方面的核心概念、底层原理、实现机制及最佳实践。

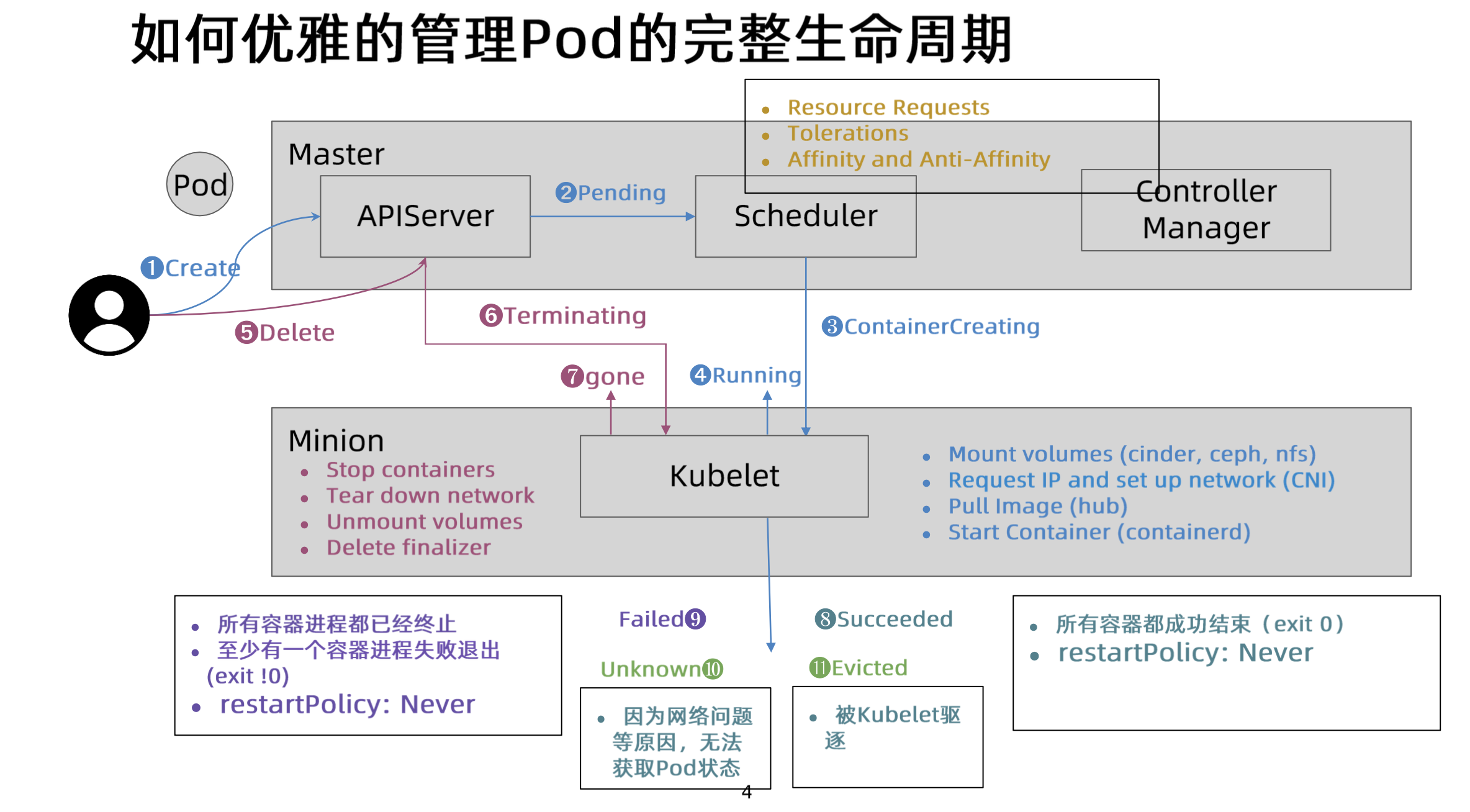

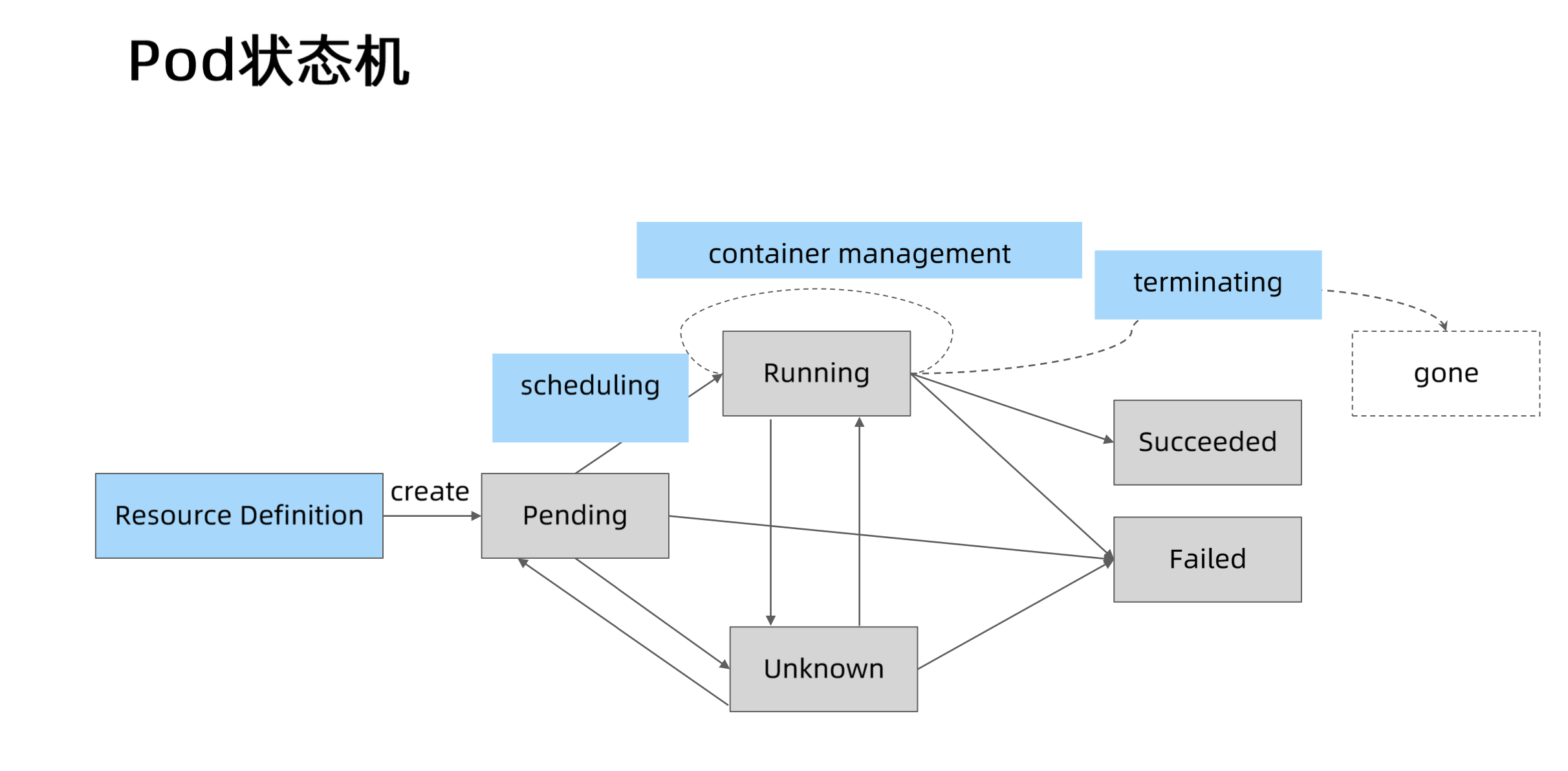

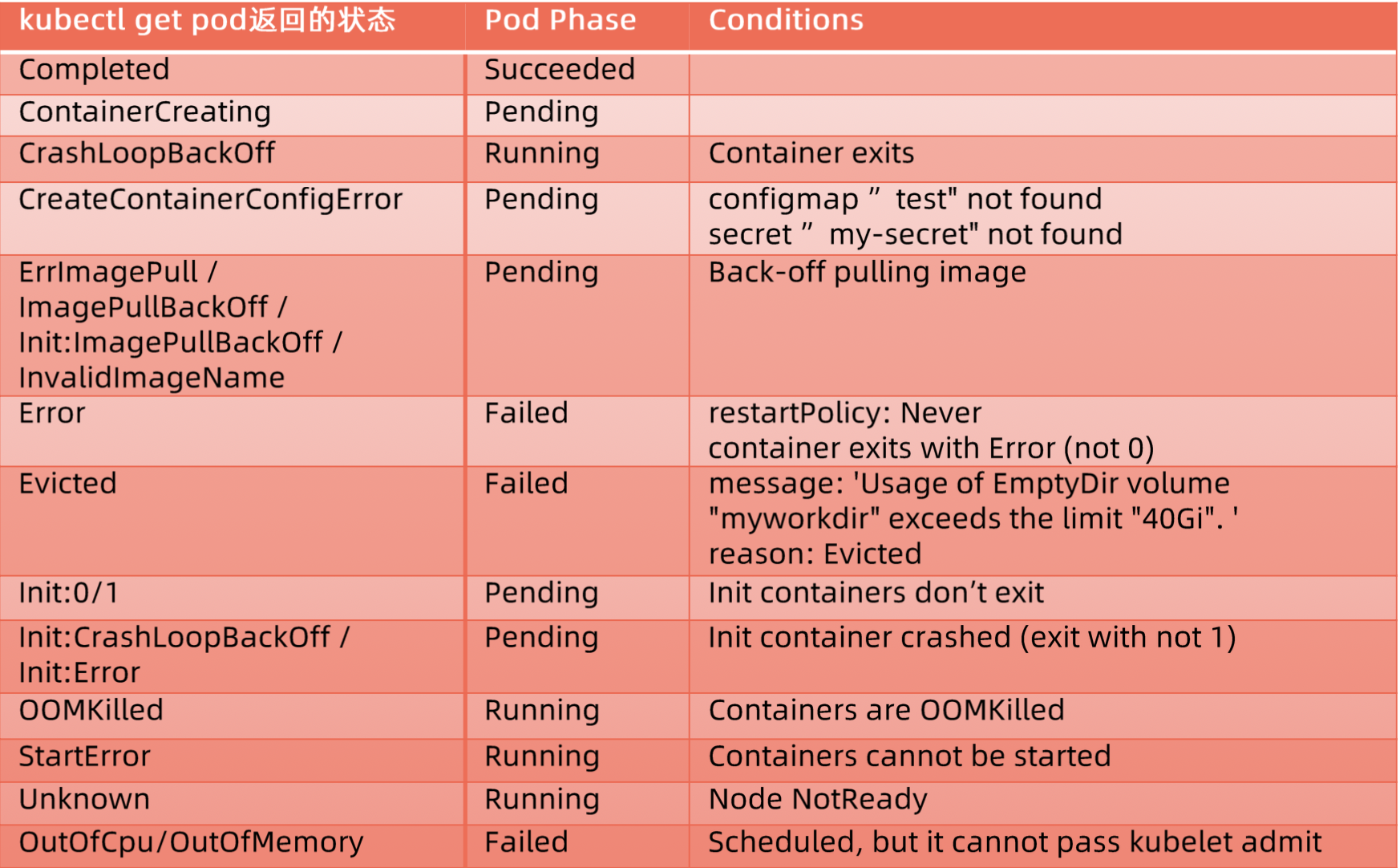

一、Pod 生命周期管理

Pod 是 Kubernetes 中最小的可部署单元。理解和管理 Pod 的生命周期对于确保应用稳定运行至关重要。Kubernetes 提供了多种机制来控制 Pod 的资源分配、健康状态和启动/终止行为。

1.1 Kubernetes QoS 类别

Kubernetes 定义了三种 QoS (Quality of Service) 类,用于决定 Pod 的调度优先级和资源抢占/驱逐策略。QoS 的设定基于容器的 resources.requests 和 resources.limits。

1. Guaranteed

- 条件:Pod 中 所有容器 都必须同时设置

requests和limits,并且 所有资源类型(如 CPU, memory)的requests值必须 严格等于limits值。 - 特性:最高优先级。这类 Pod 拥有最强的资源保障,在节点资源紧张时,它们是最后被驱逐的对象。Kubelet 会为 Guaranteed Pod 的容器设置一个较低的 OOM (Out-Of-Memory) score adjustment 值(通常是 -998),使得它们不容易被 Linux 内核的 OOM Killer 杀死。

- 场景:关键性应用,如数据库、核心业务服务。

- 示例:

1

2

3

4

5

6

7

8

9

10

11

12# ... metadata ...

spec:

containers:

- name: app

image: nginx

resources:

requests:

memory: "500Mi"

cpu: "0.5"

limits:

memory: "500Mi"

cpu: "0.5"

2. Burstable

- 条件:Pod 中至少有一个容器设置了

requests或limits,但不满足 Guaranteed 的条件(即requests和limits不完全相等,或只有部分容器设置了资源)。 - 特性:中等优先级。Pod 保证获得其

requests的资源量,并允许在节点资源有富余时,使用超过requests但不超过limits的资源。当节点资源紧张时,Burstable Pod 比 Guaranteed Pod 更容易被驱逐,其 OOM score adjustment 值会根据资源使用情况动态调整,但通常高于 Guaranteed Pod。 - 场景:大部分 Web 应用、普通业务服务。

- 示例:

1

2

3

4

5

6

7

8

9

10

11

12# ... metadata ...

spec:

containers:

- name: app

image: nginx

resources:

requests:

memory: "200Mi"

cpu: "0.2"

limits:

memory: "500Mi"

cpu: "0.5"

3. BestEffort

- 条件:Pod 中 所有容器 都没有设置

requests和limits。 - 特性:最低优先级。这类 Pod 对资源没有保证,只能使用节点上其他 Pod 剩下的空闲资源。在节点资源紧张时,它们是最先被驱逐的对象。其 OOM score adjustment 值通常最高(如 1000),最容易被 OOM Killer 杀死。

- 场景:开发测试环境、不重要的批处理任务。

- 示例:

1

2

3

4

5

6# ... metadata ...

spec:

containers:

- name: app

image: nginx

# No resources defined

QoS Class 在调度与驱逐中的运作机制

Kubernetes 的调度器 (kube-scheduler) 和节点代理 (kubelet) 在资源管理和节点压力缓解中会利用 QoS 类:

- 调度决策:调度器在选择节点时,会考虑节点的可用资源是否满足 Pod 的

requests。虽然 QoS 类本身不直接决定调度到哪个节点,但 Guaranteed 和 Burstable Pod 的requests会影响节点的资源预留计算,从而间接影响调度结果。高 QoS Pod 的资源需求更容易被满足。 - 资源分配优先级:在节点上运行时,Guaranteed Pod 的资源得到最优先保障,其次是 Burstable Pod 的

requests部分,最后是 BestEffort Pod 和 Burstable Pod 超出requests的部分。 - 节点压力驱逐 (Node Pressure Eviction):当节点出现资源压力(如

MemoryPressure,DiskPressure)时,kubelet 会按照BestEffort -> Burstable -> Guaranteed的优先级顺序驱逐 Pod 以回收资源。对于 Burstable Pod,如果其资源使用量超过了requests,它会比仅使用requests内资源的 Burstable Pod 或 Guaranteed Pod 更早被驱逐。 - OOM Killer 行为:Linux 内核的 OOM Killer 在物理内存不足时会终止进程。Kubelet 根据 QoS 类为容器进程设置

oom_score_adj值,影响 OOM Killer 的选择倾向:BestEffort (最高分,最易被杀) -> Burstable (中间值) -> Guaranteed (最低分,最不易被杀)。

1.2 健康探针 (Probes)

Kubernetes 提供三种探针来检测容器的健康状况,确保应用的可用性和自愈能力。探针由 Kubelet 在节点上执行。

Liveness Probe (存活探针)

- 核心作用:判断容器是否仍在运行且功能正常。如果探测失败达到阈值,Kubelet 会杀死该容器,并根据 Pod 的

restartPolicy决定是否重启。这是实现故障自愈 (Self-healing) 的关键。 - 实现原理:

exec: 在容器内执行命令。如果命令退出码为 0,则成功。Kubelet 通过 CRI (Container Runtime Interface) 在容器的命名空间内执行该命令。httpGet: 向容器指定 IP、端口和路径发送 HTTP GET 请求。如果响应状态码在 200-399 之间,则成功。Kubelet 通常从节点网络命名空间发起请求(需要网络可达)。tcpSocket: 尝试与容器指定 IP 和端口建立 TCP 连接。如果连接成功建立,则成功。grpc: (较新版本支持) 向容器指定端口发送 gRPC 健康检查请求。

- 典型场景:检测死锁、无法响应请求的僵尸进程、内部状态损坏等。

- 配置示例:

1

2

3

4

5

6

7

8

9livenessProbe:

httpGet:

path: /healthz

port: 8080

initialDelaySeconds: 15 # 容器启动后首次探测延迟

periodSeconds: 10 # 探测周期

timeoutSeconds: 1 # 探测超时时间

failureThreshold: 3 # 连续失败多少次后视为失败

successThreshold: 1 # 连续成功多少次后视为成功 (通常为1)

- 核心作用:判断容器是否仍在运行且功能正常。如果探测失败达到阈值,Kubelet 会杀死该容器,并根据 Pod 的

Readiness Probe (就绪探针)

- 核心作用:判断容器是否准备好接收外部流量。如果探测失败,Kubernetes 会将该 Pod 的 IP 从对应的 Service 的 Endpoints/EndpointSlices 列表中移除。这确保了流量不会被转发到尚未就绪或暂时不可用的 Pod。

- 网络层机制:Kubelet 将探测结果上报给 API Server。Endpoint Controller (或 EndpointSlice Controller) 监控 Pod 状态,并更新 Service 关联的 Endpoints/EndpointSlices 对象。kube-proxy 监控这些对象的变化,并相应地更新节点上的网络规则 (iptables/IPVS),从而控制流量转发。

- 关键应用:应用启动时的初始化(如缓存加载、数据库连接池预热)、依赖服务检查、过载保护(暂时拒绝流量)。

- 配置示例:

1

2

3

4

5

6readinessProbe:

exec:

command: ["cat", "/tmp/healthy"]

initialDelaySeconds: 5

periodSeconds: 5

failureThreshold: 3

Startup Probe (启动探针)

- 核心作用:专门用于判断容器内应用是否已成功启动。这对于启动时间较长的应用特别有用。在 Startup Probe 成功之前,Liveness 和 Readiness Probe 会被禁用。一旦 Startup Probe 成功,Kubelet 才会开始执行 Liveness 和 Readiness Probe。如果 Startup Probe 在配置的

failureThreshold * periodSeconds时间内未能成功,Kubelet 会杀死容器,如同 Liveness Probe 失败一样。 - 设计哲学:解决慢启动应用可能在 Liveness Probe 超时前就被误杀的问题,提供更长的启动缓冲期。

- 特殊场景:大型 Java 应用启动、机器学习模型加载、需要复杂初始化的应用。

- 配置示例:

1

2

3

4

5

6startupProbe:

httpGet:

path: /startupz

port: 8080

failureThreshold: 30 # 总等待时间 = 30 * 10s = 300s

periodSeconds: 10

- 核心作用:专门用于判断容器内应用是否已成功启动。这对于启动时间较长的应用特别有用。在 Startup Probe 成功之前,Liveness 和 Readiness Probe 会被禁用。一旦 Startup Probe 成功,Kubelet 才会开始执行 Liveness 和 Readiness Probe。如果 Startup Probe 在配置的

| 维度 | Liveness Probe | Readiness Probe | Startup Probe |

|---|---|---|---|

| 核心使命 | 故障自愈(Fail-Fast) | 流量管控(Graceful Handling) | 启动保护(Slow Start Shield) |

| K8s 响应动作 | 重启容器(Kill & Restart) | 从 Service Endpoints 移除/添加 | 成功前禁用 Liveness/Readiness |

| 失败影响域 | 单个 Pod 实例 | Service 流量分发 | Pod 启动阶段 |

三种探针的执行顺序与交互

- 启动阶段:容器启动后,如果配置了 Startup Probe,则首先执行它。Liveness 和 Readiness Probe 处于禁用状态。

- Startup 成功后:一旦 Startup Probe 首次成功,它便不再执行。Kubelet 立即开始按照各自的

initialDelaySeconds和periodSeconds调度 Liveness 和 Readiness Probe。 - 无 Startup Probe:如果未配置 Startup Probe,Liveness 和 Readiness Probe 会在各自的

initialDelaySeconds后开始独立执行。 - 并发执行:Liveness 和 Readiness Probe (在 Startup 成功后或无 Startup 时) 是并发独立执行的,它们的结果互不影响对方的执行,但共同决定 Pod 的状态和流量接收能力。

探针常见属性详解

initialDelaySeconds: 首次探测前的延迟时间。必须仔细设置,避免应用未完全初始化就被探测。periodSeconds: 探测执行的频率。影响问题发现的速度和探测开销。timeoutSeconds: 每次探测允许的最长时间。应小于periodSeconds。设置过短可能导致网络抖动下的误判。failureThreshold: 连续探测失败多少次后,判定为最终失败。增加此值可容忍瞬时故障。successThreshold: 从失败状态恢复时,需要连续探测成功多少次才判定为成功。对于 Readiness Probe,设置大于 1 可防止状态抖动(Flapping)。terminationGracePeriodSeconds(Pod 级别): 虽然不是探针属性,但影响 Liveness Probe 失败后的容器终止过程。Kubelet 发送 SIGTERM 后会等待 SIGKILL。

探针类型专属参数

- HTTP GET:

path,port,host,scheme,httpHeaders。host默认为 Pod IP,可指定为127.0.0.1强制探测容器内部。 - TCP Socket:

port,host。 - Exec:

command。命令在容器内执行,其资源消耗计入容器配额。

典型故障模式分析

| 故障现象 | 根本原因 | 解决方案 |

|---|---|---|

| 容器无限重启循环 | Liveness initialDelaySeconds 或 timeoutSeconds 过短;Startup Probe 未配置或 failureThreshold 不足 |

调整探针参数;配置合适的 Startup Probe |

| Service 流量丢失 | Readiness Probe 失败;探测逻辑本身有误 | 检查应用状态;修复探测逻辑;调整 failureThreshold |

| 节点 CPU/网络 飙升 | 探测 periodSeconds 过短;exec 探针脚本复杂 |

增大 periodSeconds;优化脚本或改用 HTTP/TCP |

1.3 Readiness Gates

readinessGates 是一个高级特性,允许将 Pod 的就绪状态(是否加入 Service Endpoints)与外部或自定义的条件关联起来。传统的 Readiness Probe 只检查容器内部状态,而 readinessGates 可以等待集群级别的资源(如网络策略应用完成)或外部依赖(如数据库迁移完成)就绪。

核心设计原理

- 扩展状态判定:Pod 的最终就绪状态不仅取决于其容器的 Readiness Probe 结果,还取决于

readinessGates中列出的所有条件的status是否为True。1

Pod Ready = (All Containers Ready) AND (All Readiness Gates Conditions are True) - 条件注入:这些额外的条件状态通常由自定义控制器 (Operator) 或 Admission Webhook 监控相关资源或外部系统,并通过更新 Pod 的

.status.conditions字段来注入。 - 控制面协同:Kubelet 检查容器 Readiness Probe。Endpoint Controller 检查容器就绪状态和所有

readinessGates条件的状态,共同决定是否将 Pod IP 加入 Endpoints/EndpointSlices。

关键技术特性

- 条件类型注册:在 Pod Spec 中定义需要关注的条件类型。

1

2

3

4

5

6

7

8

9

10apiVersion: v1

kind: Pod

metadata:

name: myapp

spec:

readinessGates:

- conditionType: "www.example.com/ExternalServiceRegistered" # 自定义条件

- conditionType: "storage.example.com/VolumeAttached" # 可能由 CSI 驱动注入

containers:

# ... container definition ... - 条件状态结构:Pod Status 中对应的条件结构。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25"status": {

"conditions": [

{

"type": "Ready", // 内建条件,表示容器是否就绪

"status": "True", ...

},

{

"type": "ContainersReady", // 内建条件

"status": "True", ...

},

{

"type": "www.example.com/ExternalServiceRegistered", // 自定义条件

"status": "True", // 由外部控制器更新

"lastProbeTime": null,

"lastTransitionTime": "2023-10-27T10:00:00Z",

"reason": "Registered",

"message": "Successfully registered with the external discovery service."

},

{

"type": "storage.example.com/VolumeAttached",

"status": "False", // 假设尚未就绪

...

}

], ...

}

生产环境典型场景

- 服务网格集成:等待 Sidecar (如 Istio Envoy) 完全初始化并准备好代理流量。

1

2readinessGates:

- conditionType: "proxy.istio.io/ready" - 存储系统验证:等待 CSI 驱动程序成功挂载并准备好持久卷。

- 数据库迁移:等待数据库 Schema 迁移任务完成。

- 配置同步:等待 ConfigMap 或 Secret 更新被应用感知并加载。

- 多集群/外部依赖:等待跨集群资源同步或外部服务注册完成。

与传统 Readiness Probe 对比

| 维度 | Readiness Probe | Readiness Gates |

|---|---|---|

| 检测触发源 | Kubelet 主动探测 | 外部控制器/系统被动通知 |

| 检测范围 | 容器内部状态 | 集群级/外部系统状态 |

| 关注点 | 容器自身是否健康 | Pod 是否满足服务依赖条件 |

| 实现 | Kubelet 内建 | 自定义控制器 + API 更新 |

最佳实践

- 命名规范:条件类型使用域名反转格式,避免冲突。

- 状态监控:监控自定义条件的状态和更新延迟。

- 控制器健壮性:确保更新条件的控制器自身高可用且逻辑正确。

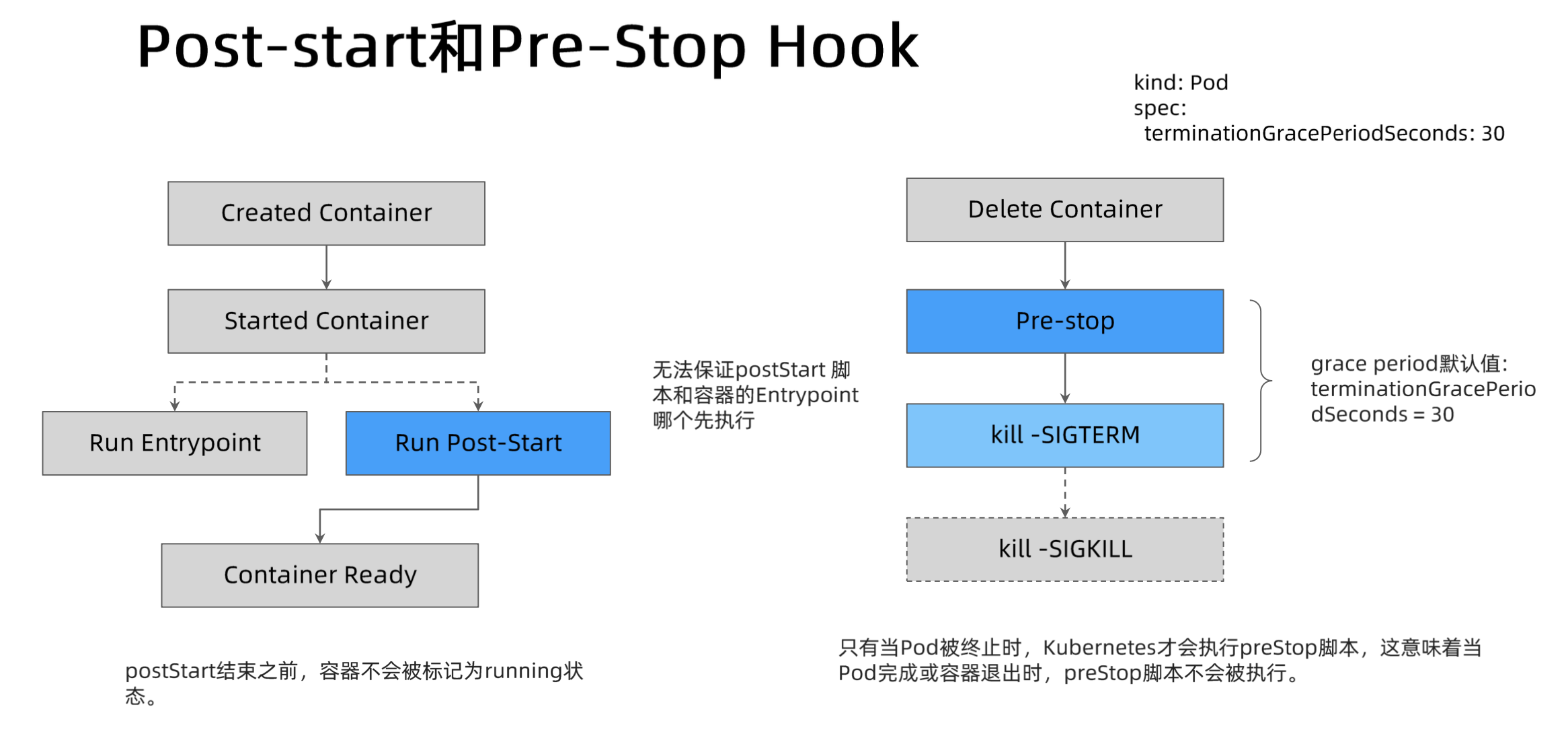

1.4 Lifecycle Hooks

Lifecycle Hooks 允许在容器生命周期的关键节点执行特定的操作,例如在容器启动后执行初始化任务,或在容器终止前执行清理操作。

postStart Hook

- 触发时机:在容器创建后立即执行。注意,它与容器的入口点 (ENTRYPOINT/CMD) 命令是异步执行的,不保证在入口点命令之前完成。

- 执行方式:

exec: 在容器内执行一个命令。httpGet: 向容器内的一个端点发送 HTTP GET 请求。

- 用途:执行初始化任务,如注册服务、预加载数据等。但由于其异步性,不适合用于阻塞应用启动的关键依赖。如果 Hook 执行失败,容器会被杀死。

- 示例:

1

2

3

4lifecycle:

postStart:

exec:

command: ["/bin/sh", "-c", "echo Container started > /var/log/startup.log"]

preStop Hook

- 触发时机:在容器被终止之前执行。当 Kubelet 决定终止容器时(例如 Pod 删除、Liveness Probe 失败),会先执行

preStopHook,然后再向容器发送 SIGTERM 信号。 - 同步特性:

preStopHook 是阻塞的。Kubelet 会等待 Hook 执行完成(或超时)后,才发送 SIGTERM。整个优雅终止过程(Hook 执行 + 等待 SIGTERM 响应)的总时间受 Pod 的terminationGracePeriodSeconds限制。 - 用途:执行优雅关闭 (Graceful Shutdown) 操作,如保存状态、关闭连接、从服务注册中心注销、完成正在处理的请求等。

- 示例:

1

2

3

4lifecycle:

preStop:

exec:

command: ["/usr/sbin/nginx", "-s", "quit"] # Nginx 优雅关闭命令

- 触发时机:在容器被终止之前执行。当 Kubelet 决定终止容器时(例如 Pod 删除、Liveness Probe 失败),会先执行

注意事项

- 执行保证:Lifecycle Hooks 的执行至少会被尝试一次。

- 资源消耗:

exec类型的 Hook 执行会消耗容器的资源。 - 超时与终止:如果 Hook 执行时间过长,超过

terminationGracePeriodSeconds(对于preStop) 或内部超时 (对于postStart),容器可能会被强制终止 (SIGKILL)。 - 与探针的关系:

postStart在探针开始探测之前执行。preStop在容器被标记为 Terminating 状态后执行,此时 Readiness Probe 通常已失败(或即将失败)。

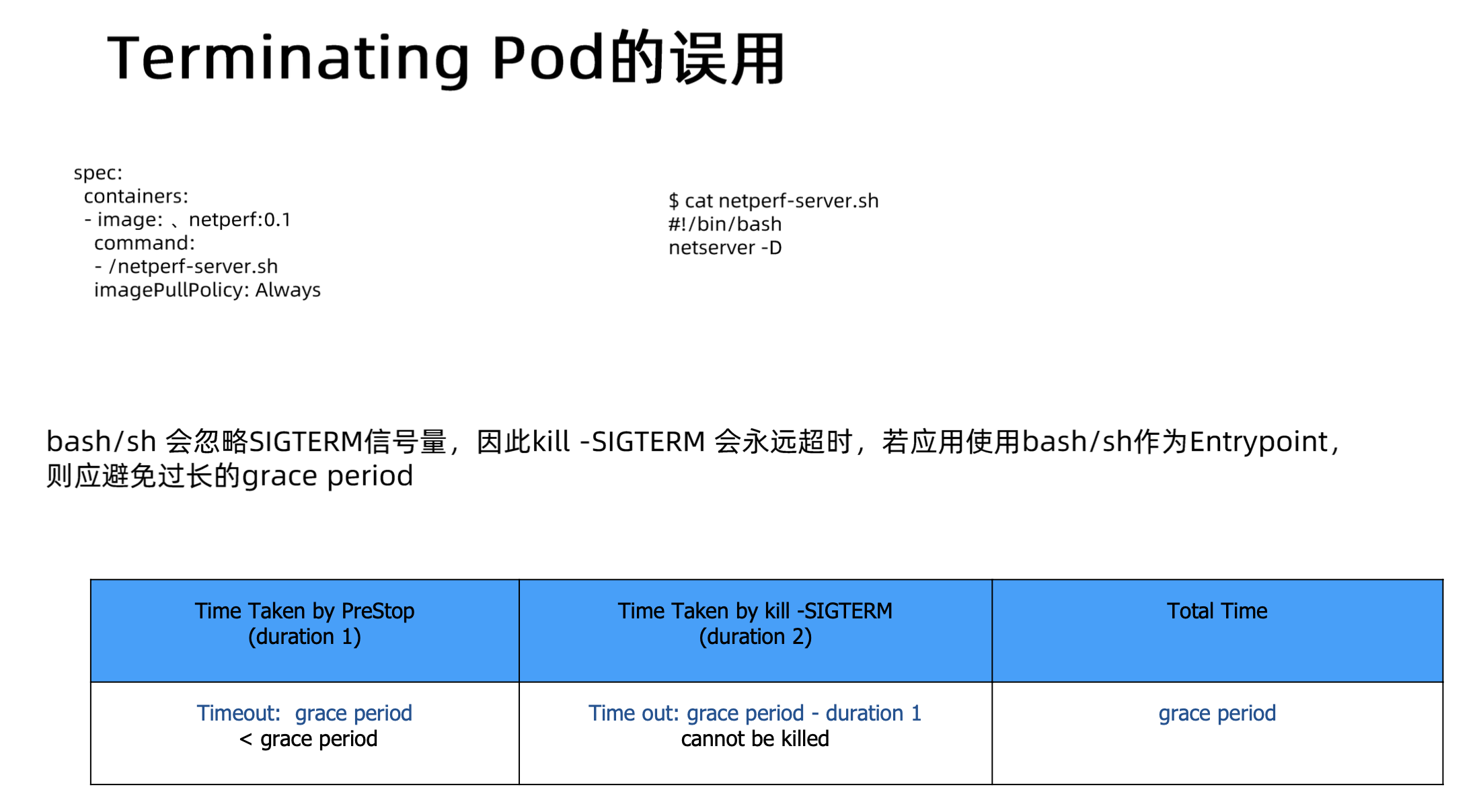

1.5 优雅终止 (TerminationGracePeriodSeconds)

terminationGracePeriodSeconds 是 Pod Spec 中的一个字段,定义了从 Pod 被请求删除到其容器被强制终止 (SIGKILL) 之间的最大宽限时间(默认 30 秒)。这是实现应用优雅关闭的关键参数。

Pod 删除流程详解

- API 请求:用户或控制器通过 API Server 请求删除 Pod。

- 状态更新:Pod 对象被标记为

Terminating状态,并记录deletionTimestamp。 - Endpoint 移除:Endpoint Controller 将该 Pod 从 Service 的 Endpoints/EndpointSlices 中移除(基于 Readiness 状态和

Terminating状态)。此时,新的流量不再会路由到该 Pod。 - preStop Hook 执行:如果定义了

preStopHook,Kubelet 会执行它。 - SIGTERM 发送:

preStopHook 执行完成后(或 Pod 没有preStopHook),Kubelet 向 Pod 中的每个容器的主进程发送 SIGTERM 信号。 - 等待期:Kubelet 开始计时,等待

terminationGracePeriodSeconds定义的时长。容器内的应用应该捕获 SIGTERM 信号,并开始执行清理工作(如完成当前请求、保存数据、关闭连接)。 - 容器退出:如果容器在宽限期内自行退出(退出码 0 或非 0 均可),则优雅终止完成。

- SIGKILL 发送:如果在

terminationGracePeriodSeconds结束后,容器仍未退出,Kubelet 会向其发送 SIGKILL 信号,强制终止进程。 - 资源清理:Kubelet 清理与 Pod 相关的资源(如网络、存储)。

- API 对象删除:Pod 对象最终从 API Server 中删除。

配置与最佳实践

- 设置合理值:

terminationGracePeriodSeconds的值应大于应用完成优雅关闭所需的最长时间(包括preStopHook 执行时间和处理 SIGTERM 的时间)。 - 应用实现:应用程序必须能够正确处理 SIGTERM 信号,并在此信号触发时执行必要的清理逻辑。

- 立即删除:可以通过

kubectl delete pod <pod-name> --grace-period=0 --force来强制立即删除 Pod(跳过优雅终止期,直接发送 SIGKILL),但这通常只在调试或紧急情况下使用,可能导致数据丢失或状态不一致。

二、高可用部署与更新策略

在生产环境中,保证应用的持续可用性至关重要。Kubernetes 提供了多种机制来实现高可用部署和无缝更新。

2.1 副本数量与冗余

通过运行多个应用的多个副本(Pods),可以提高容错能力和负载处理能力。这通常通过 Deployment, StatefulSet, 或 ReplicaSet 控制器实现。

replicas字段:指定期望运行的 Pod 副本数量。控制器会持续监控实际运行的 Pod 数量,并在数量不足时创建新的 Pod,在数量过多时删除多余的 Pod。- 设计考量:

- SLA 要求:根据服务等级协议确定所需的最小可用副本数。

- 负载预估:根据预期流量和单个 Pod 的处理能力确定副本数。

- 故障域分散:结合 Pod 反亲和性 (Pod Anti-Affinity) 或拓扑分布约束 (Topology Spread Constraints) 将副本分散到不同的节点、可用区或地域,避免单点故障影响。

2.2 滚动更新策略 (Rolling Updates)

滚动更新是 Kubernetes Deployment 默认的更新策略,它允许在不中断服务的情况下逐步替换旧版本的 Pod。

工作方式:逐个或分批次地创建新版本的 Pod,同时停止旧版本的 Pod,确保在整个更新过程中,始终有一定数量的 Pod 在运行并提供服务。

关键参数 (

spec.strategy.rollingUpdate):maxUnavailable: 更新过程中允许的最大不可用 Pod 数量(相对于replicas)。可以是绝对数值(如1)或百分比(如25%)。默认值为25%。例如,replicas=4,maxUnavailable=1,表示更新时至少要有 3 个 Pod 可用。maxSurge: 更新过程中允许创建的、超过replicas数量的最大额外 Pod 数量。可以是绝对数值(如1)或百分比(如25%)。默认值为25%。例如,replicas=4,maxSurge=1,表示更新时最多可以有 5 个 Pod 同时存在(新旧版本 Pod 总数)。

与 ResourceQuota 的关系:如果设置了较高的

maxSurge,更新时可能会临时需要更多资源(CPU, Memory)。如果命名空间设置了 ResourceQuota,需要确保配额足够容纳这些额外的 Pod,否则更新可能会失败。PodTemplateHash:Deployment 控制器通过在 ReplicaSet 和 Pod 上添加

pod-template-hash标签来区分不同版本的 Pod。每次更新spec.template都会生成一个新的 hash,触发滚动更新。

2.3 PodDisruptionBudget (PDB)

PDB 是一种保护机制,用于限制在自愿性中断(如节点维护 kubectl drain、集群升级)期间,同时可以有多少个属于某个应用(由标签选择器定义)的 Pod 被中断。这确保了即使在维护操作期间,应用也能维持最低的可用性。

- 关键参数:

minAvailable: 指定在中断期间必须保持可用的 Pod 的最小数量或百分比。maxUnavailable: 指定在中断期间允许同时不可用的 Pod 的最大数量或百分比。注意:minAvailable和maxUnavailable只能设置其中一个。

- 工作原理:当执行可能导致 Pod 被驱逐的操作时(如

kubectl drain),Kubernetes 会检查相关的 PDB。如果驱逐某个 Pod 会导致低于minAvailable或超过maxUnavailable的限制,则该驱逐操作会被阻塞,直到可以安全地驱逐为止。 - 重要性:PDB 对于保障关键应用在计划内维护期间的服务连续性至关重要。它不防止非自愿性中断(如节点崩溃)。

三、Kubernetes 服务发现

在动态的容器环境中,Pod 的 IP 地址和数量会频繁变化。服务发现机制解决了“一个服务如何找到并访问另一个服务”的问题。

3.1 服务发现的必要性与挑战

微服务架构下,应用被拆分成多个独立的服务。这些服务需要相互通信。

- 必要性:

- 动态性:Pod 是短暂的,它们的 IP 会在重启、扩缩容、更新时改变。客户端不能硬编码 Pod IP。

- 负载均衡:通常一个服务有多个副本,客户端需要将请求分发到这些副本上。

- 解耦:服务消费者不应关心服务提供者的具体位置和数量。

- 挑战:

- IP 地址管理:如何为服务提供一个稳定的访问入口?

- 实例发现:如何动态获取服务提供者的健康实例列表?

- 负载均衡实现:如何在多个实例间分发流量?

- DNS 缓存:传统 DNS 缓存可能导致服务 IP 变更感知延迟。

- 跨集群/地域:如何在多集群或混合云环境中实现服务发现?

3.2 Kubernetes Service 核心机制

Service 是 Kubernetes 中实现服务发现和负载均衡的核心抽象。它为一组功能相同的 Pod 提供了一个稳定的虚拟 IP 地址 (ClusterIP) 和 DNS 名称。

Service 类型

ClusterIP (默认类型)

- 作用:为 Service 分配一个集群内部唯一的虚拟 IP 地址。该 IP 只能在集群内部访问。

- 实现:kube-proxy 在每个节点上维护网络规则(iptables 或 IPVS),将发往 ClusterIP:Port 的流量负载均衡到后端健康的 Pod IP:TargetPort。

- 用途:集群内部服务之间的通信。

NodePort

- 作用:在 ClusterIP 的基础上,额外在每个节点上暴露一个静态端口 (NodePort)。外部客户端可以通过

NodeIP:NodePort访问 Service。 - 实现:kube-proxy 负责将

NodeIP:NodePort的流量转发给 Service 的 ClusterIP(或直接转发给 Pod)。 - 用途:将服务暴露给集群外部(通常用于测试或非生产环境,或作为外部 LB 的后端)。端口范围默认 30000-32767。

- 作用:在 ClusterIP 的基础上,额外在每个节点上暴露一个静态端口 (NodePort)。外部客户端可以通过

LoadBalancer

- 作用:在 NodePort 的基础上,进一步向云提供商请求一个外部负载均衡器 (ELB, GLB 等)。云提供商的 LB 会将外部流量路由到各个节点的

NodeIP:NodePort。 - 实现:需要云提供商的 Cloud Controller Manager 支持。它会自动创建、配置外部 LB,并将外部 IP 写入 Service 的

status.loadBalancer.ingress字段。 - 用途:将服务标准地暴露给公网或外部网络。

- 作用:在 NodePort 的基础上,进一步向云提供商请求一个外部负载均衡器 (ELB, GLB 等)。云提供商的 LB 会将外部流量路由到各个节点的

ExternalName

- 作用:不分配 ClusterIP,也不代理任何 Pod。它将 Service 名称映射到一个外部域名 (CNAME 记录)。

- 实现:集群内部的 DNS 服务(如 CoreDNS)会为该 Service 名称返回一个 CNAME 记录,指向

spec.externalName指定的域名。 - 用途:让集群内部的应用通过 Kubernetes Service 名称访问集群外部的服务,提供一层抽象。

kube-proxy 工作模式

kube-proxy 是运行在每个节点上的网络代理,负责实现 Service 的路由和负载均衡规则。主要有两种模式:

- iptables (较早,广泛使用)

- 原理:为每个 Service 创建大量的 iptables 规则,进行 DNAT (目标地址转换) 和负载均衡。

- 优点:成熟稳定。

- 缺点:当 Service 和 Endpoints 数量巨大时,iptables 规则数量激增,性能下降,规则更新延迟变大。规则是顺序匹配,效率不高。

- IPVS (IP Virtual Server) (较新,性能更好)

- 原理:使用 Linux 内核的 IPVS 模块,基于哈希表进行转发,效率更高。

- 优点:性能好,尤其在大规模集群中。支持更丰富的负载均衡算法。

- 缺点:需要节点内核支持 IPVS 模块。

Endpoints 与 EndpointSlices

- Endpoints:早期 Kubernetes 版本中,每个 Service 对应一个 Endpoints 对象,其中包含了该 Service 代理的所有健康 Pod 的 IP 地址和端口列表。当 Service 或 Pod 发生变化时,Endpoints 对象会被更新。

- EndpointSlices (Kubernetes 1.16+ 引入,1.21+ 默认启用)

- 目的:解决 Endpoints 对象在 Pod 数量巨大时变得过大、更新效率低的问题。

- 原理:将一个 Service 的 Endpoints 拆分成多个 EndpointSlice 对象。每个 Slice 包含一部分 Pod 的 IP 和端口。这样更新时只需修改涉及到的 Slice,提高了可伸缩性和性能。

Headless Service

- 定义:通过将

spec.clusterIP设置为None创建的 Service。 - 特点:

- Kubernetes 不会为 Headless Service 分配 ClusterIP。

- kube-proxy 不会处理这种 Service,即不提供负载均衡和代理。

- DNS 配置不同:

- 对于普通的 Headless Service(有 Selector),DNS 会返回所有后端 Pod 的 IP 地址 (A 记录)。

- 对于 StatefulSet 管理的 Pod,结合 Headless Service,可以为每个 Pod 提供一个唯一的、稳定的 DNS 名称,格式通常为

<pod-name>.<headless-service-name>.<namespace>.svc.<cluster-domain>。

- 用途:

- 直接 Pod 访问:允许客户端自己发现所有 Pod IP,并实现自定义的负载均衡或直接连接特定 Pod。

- StatefulSet 服务发现:为有状态应用的每个实例提供稳定的网络标识。

- 数据库集群等需要点对点通信的场景。

3.3 DNS 在 Kubernetes 中的作用 (CoreDNS)

集群 DNS 是 Kubernetes 服务发现的关键组件,通常由 CoreDNS 提供。

- 功能:为 Service 和 Pod 提供 DNS 解析服务。

- 记录类型:

- Service A 记录:

my-svc.my-namespace.svc.cluster-domain.example解析到 Service 的 ClusterIP。 - Headless Service A 记录:

my-headless-svc.my-namespace.svc.cluster-domain.example解析到所有后端 Pod 的 IP 地址列表。 - Pod A 记录 (需要配置):

pod-ip-address.my-namespace.pod.cluster-domain.example解析到 Pod 的 IP 地址(通常格式为 IP 地址中的点替换为短横线)。 - StatefulSet Pod A 记录:

<pod-name>.<headless-svc-name>.<namespace>.svc.cluster-domain.example解析到特定 Pod 的 IP。 - SRV 记录:可以解析 Service 的端口信息。

- Service A 记录:

- 配置:Pod 默认使用集群 DNS 进行解析(通过

/etc/resolv.conf配置)。 - CoreDNS:是一个灵活、可扩展的 DNS 服务器,通过插件机制实现 Kubernetes 的服务发现逻辑。

3.4 服务发现面临的挑战(回顾与深化)

- DNS TTL 与缓存:客户端或节点 DNS 缓存可能导致 Service IP 或 Pod IP 变更后解析到旧地址。Kubernetes 内部 DNS TTL 通常较短,但外部或应用层缓存仍需注意。

- kube-proxy 性能瓶颈:iptables 模式在大规模集群下可能成为瓶颈。IPVS 模式性能更好,但仍有其限制。

- Pod 动态性影响:频繁的 Pod 启停会导致 Endpoints/EndpointSlices 频繁更新,增加控制面和数据面(kube-proxy 更新规则)的压力。

- 七层协议支持有限:原生 Service 主要工作在 L4 (TCP/UDP),对于 gRPC 等需要 L7 感知的负载均衡和路由支持不足(需要 Ingress 或 Service Mesh)。

- 跨集群/多集群发现:原生 Service 作用域限制在单个集群内。跨集群服务发现需要额外的解决方案(如 KubeFed, Submariner, Service Mesh)。

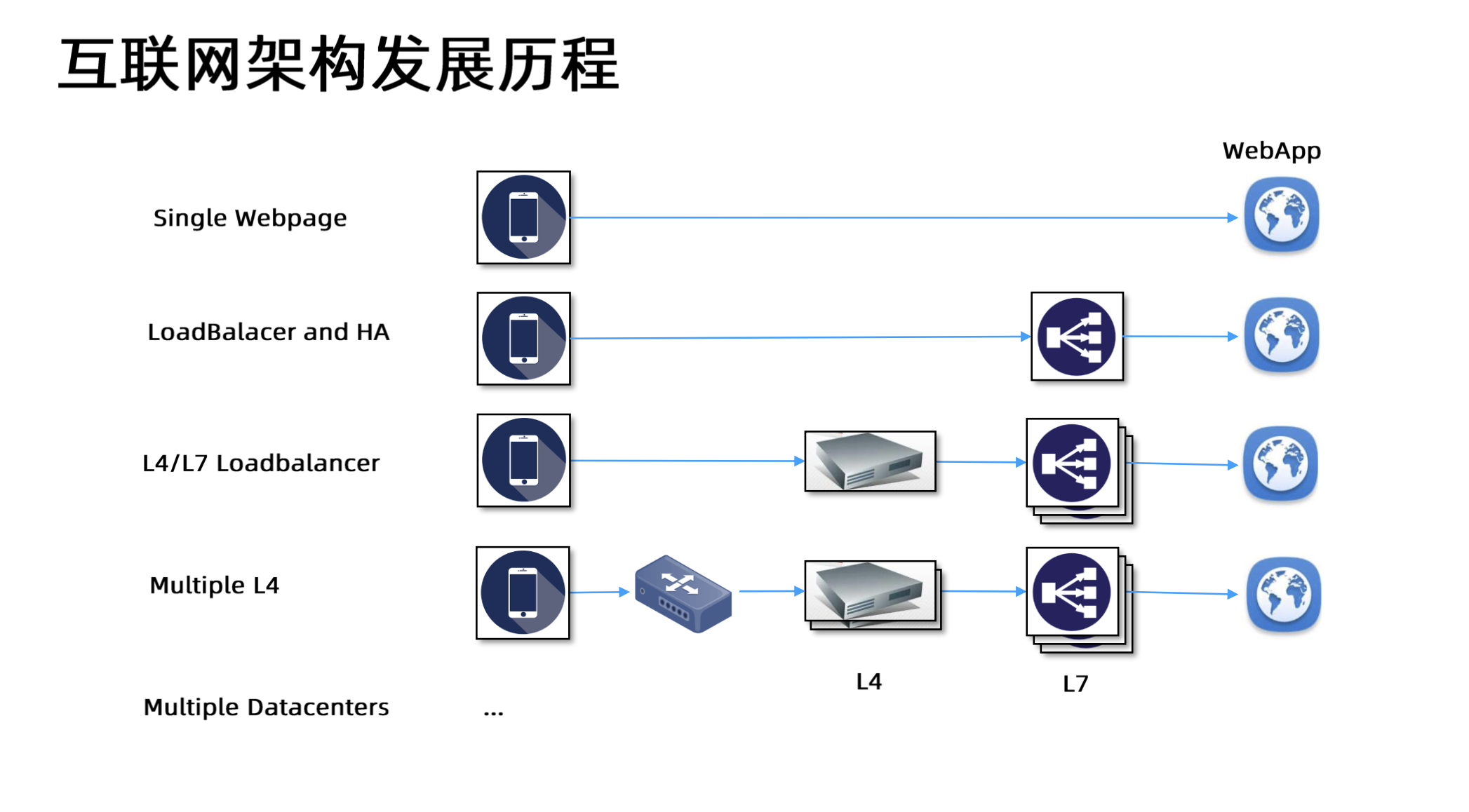

四、Kubernetes 负载均衡

负载均衡是将网络流量分发到多个后端服务实例的过程,旨在提高应用的可用性、可靠性和性能。Kubernetes 提供了多种层级的负载均衡机制。

4.1 负载均衡基础

- 目的:

- 提高吞吐量和性能:将请求分散到多个服务器处理。

- 实现高可用:当某个实例故障时,将流量切换到健康实例。

- 提供伸缩性:方便地添加或移除后端实例。

- 扩展方式:

- 纵向扩展:增加单个服务器的处理能力(CPU, RAM)。有物理上限。

- 横向扩展:增加服务器数量,通过负载均衡器分发流量。分布式系统的常用方式。

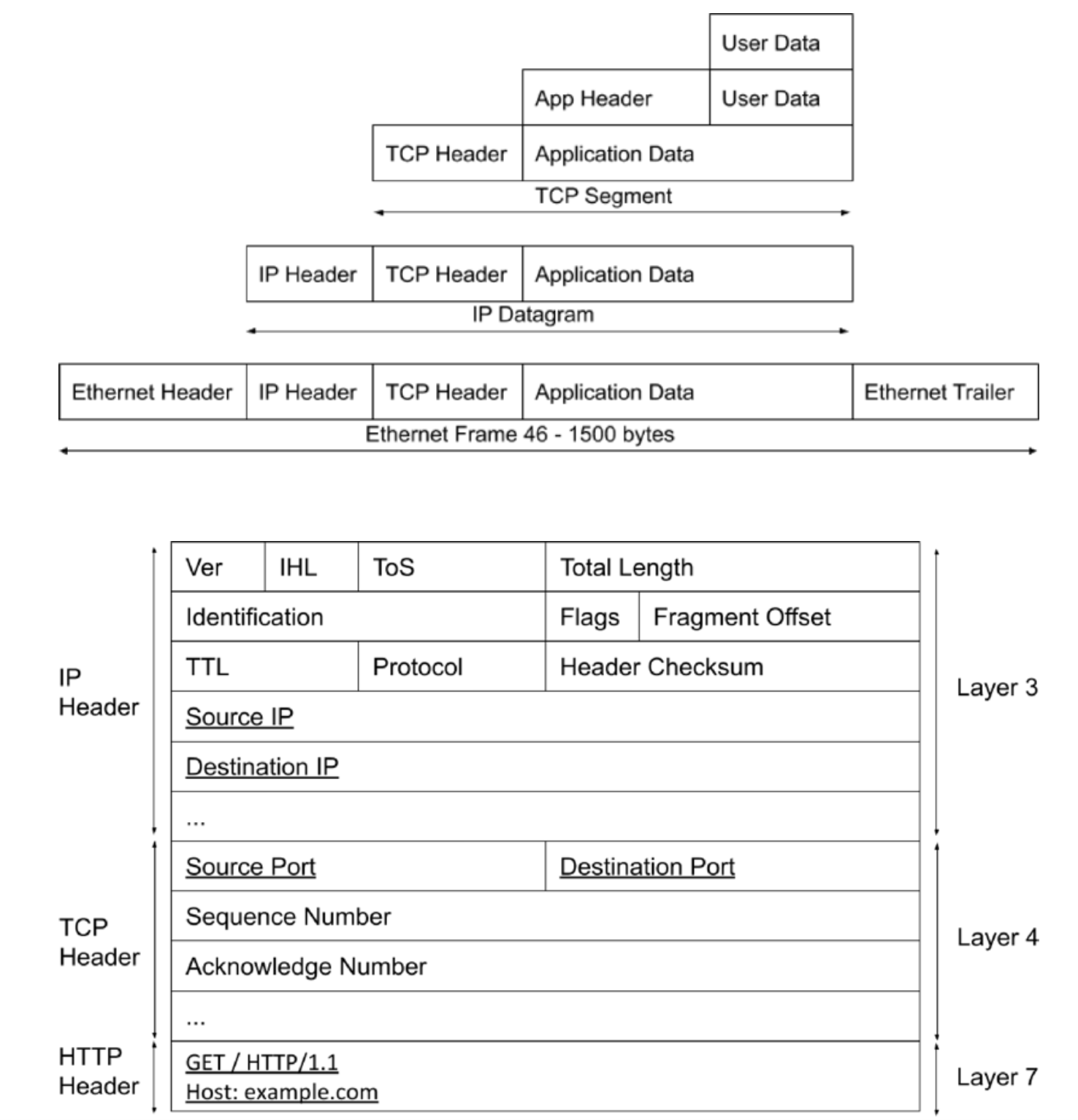

4.2 网络基础回顾 (关联 L4/L7)

理解网络包格式有助于理解不同负载均衡器的工作原理。

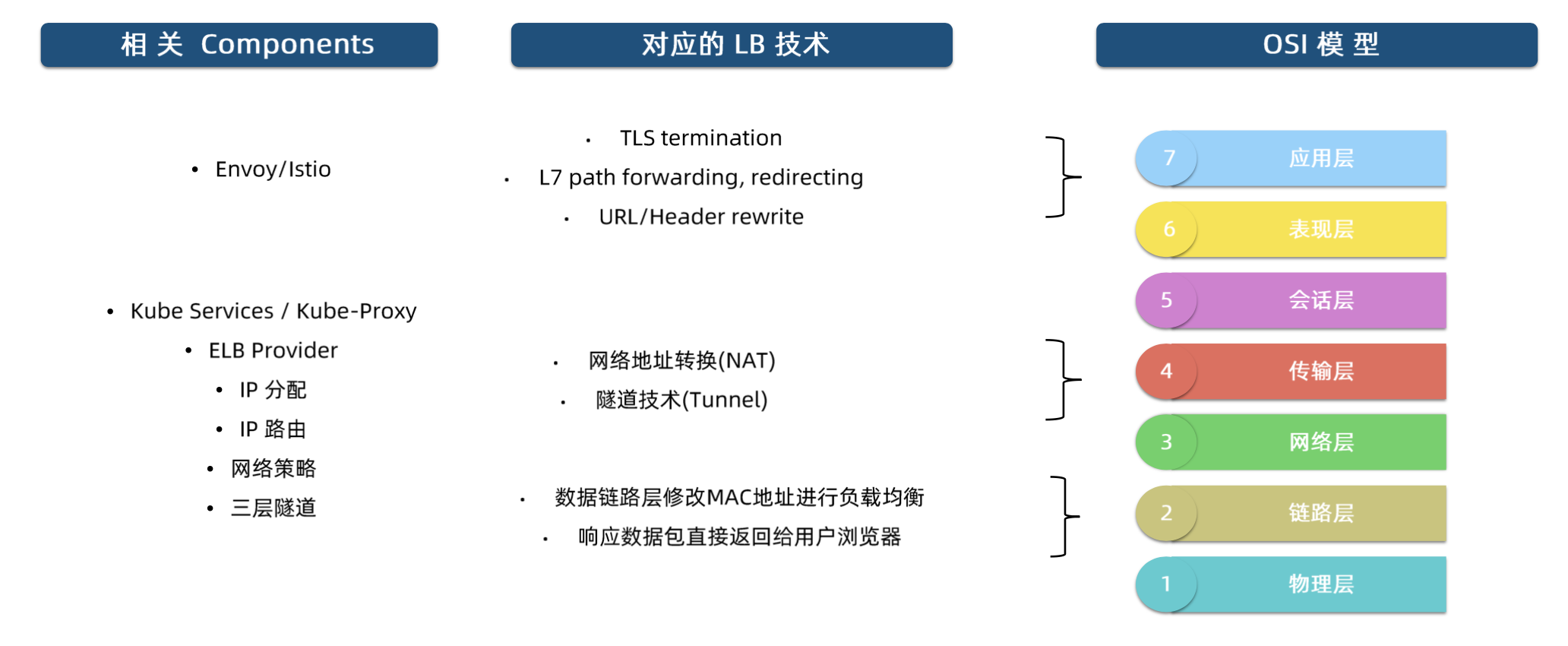

L4 负载均衡 (传输层):

- 工作在 OSI 第 4 层 (TCP/UDP)。

- 基于 IP 地址 和 端口号 (四元组:源IP、源端口、目标IP、目标端口) 来转发流量。

- 不关心应用层数据内容 (如 HTTP Header)。

- 优点:性能高,处理速度快。

- 缺点:无法基于应用内容(如 URL 路径、请求头)进行智能路由。

- Kubernetes 体现:

Service(ClusterIP, NodePort) 主要由 kube-proxy 实现 L4 负载均衡。

L7 负载均衡 (应用层):

- 工作在 OSI 第 7 层 (HTTP, HTTPS, gRPC 等)。

- 能够解析应用层协议数据。

- 基于应用内容(如 HTTP URL 路径、Host 头、Cookie、请求头等)进行更精细的流量分发和路由决策。

- 优点:功能强大,路由灵活(如基于路径的路由、基于 Header 的路由、灰度发布、A/B 测试)。可以实现 SSL 卸载、内容缓存、请求重写等高级功能。

- 缺点:需要解析应用层数据,处理开销更大,性能相对 L4 较低。

- Kubernetes 体现:

Ingress资源及其控制器 (Nginx Ingress, Traefik 等) 实现 L7 负载均衡。Service Mesh (如 Istio, Linkerd) 也提供强大的 L7 流量管理能力。

4.3 Kubernetes 中的负载均衡实现

1. Service ClusterIP / NodePort (L4 LB via kube-proxy)

- 如前所述,kube-proxy 通过 iptables 或 IPVS 规则,将发往 Service ClusterIP 或 NodePort 的 TCP/UDP 流量负载均衡到后端健康的 Pod。

- 默认使用随机或轮询(取决于模式和版本)策略。IPVS 支持更多算法(如最小连接数、加权轮询等)。

- 这是 Kubernetes 内建的、最基础的负载均衡形式。

2. Service LoadBalancer (外部云厂商 L4/L7 LB)

- 请求云提供商创建一个外部负载均衡器。

- 这个外部 LB 通常是 L4 LB(如 AWS Classic ELB, GCP Network LB),将流量转发到节点的 NodePort。

- 部分云厂商的实现也支持 L7 LB(如 AWS ALB, GCP HTTP(S) LB),可以直接与 Pod 通信(需要特定的 CNI 或集成方式)。

- 配置和能力受限于云提供商。

3. Ingress (L7 LB)

- Ingress 资源:定义了将外部 HTTP/HTTPS 流量路由到集群内部 Service 的规则(如基于 Host 或 Path)。

- Ingress 控制器:是一个实际运行的负载均衡器(通常是 Pod),它读取 Ingress 资源,并根据规则配置自身(如 Nginx, HAProxy, Traefik 等)来处理外部流量。

- 工作流程:外部流量 -> (外部 LB, 可选) -> Ingress 控制器 Pod -> Service -> 后端 Pod。

- 优点:提供标准的 L7 路由、SSL/TLS 终止、基于名称的虚拟主机等。

- 常见控制器对比:

- Nginx Ingress: 功能丰富,社区活跃,性能较好。

- Traefik: 配置简单,自动发现能力强,原生支持 Let’s Encrypt。

- HAProxy Ingress: 高性能,稳定。

- Envoy-based (Istio Gateway, Contour, Emissary-ingress): 云原生设计,功能强大,常与 Service Mesh 结合。

4.4 不同负载均衡模式探讨 (关联 K8s 实践)

除了 Kubernetes 内建的 Service 和 Ingress,还有其他负载均衡模式在微服务和云原生场景中常见,它们可以与 Kubernetes 结合或作为其补充。

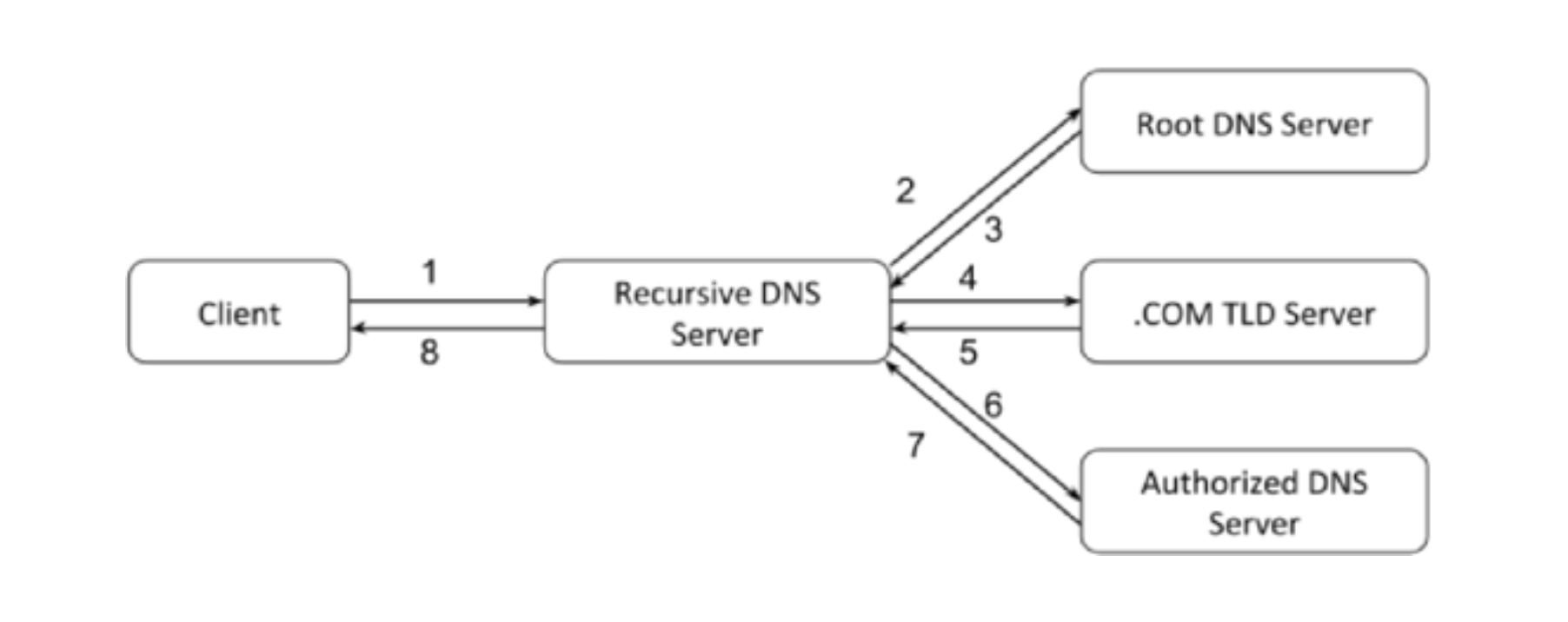

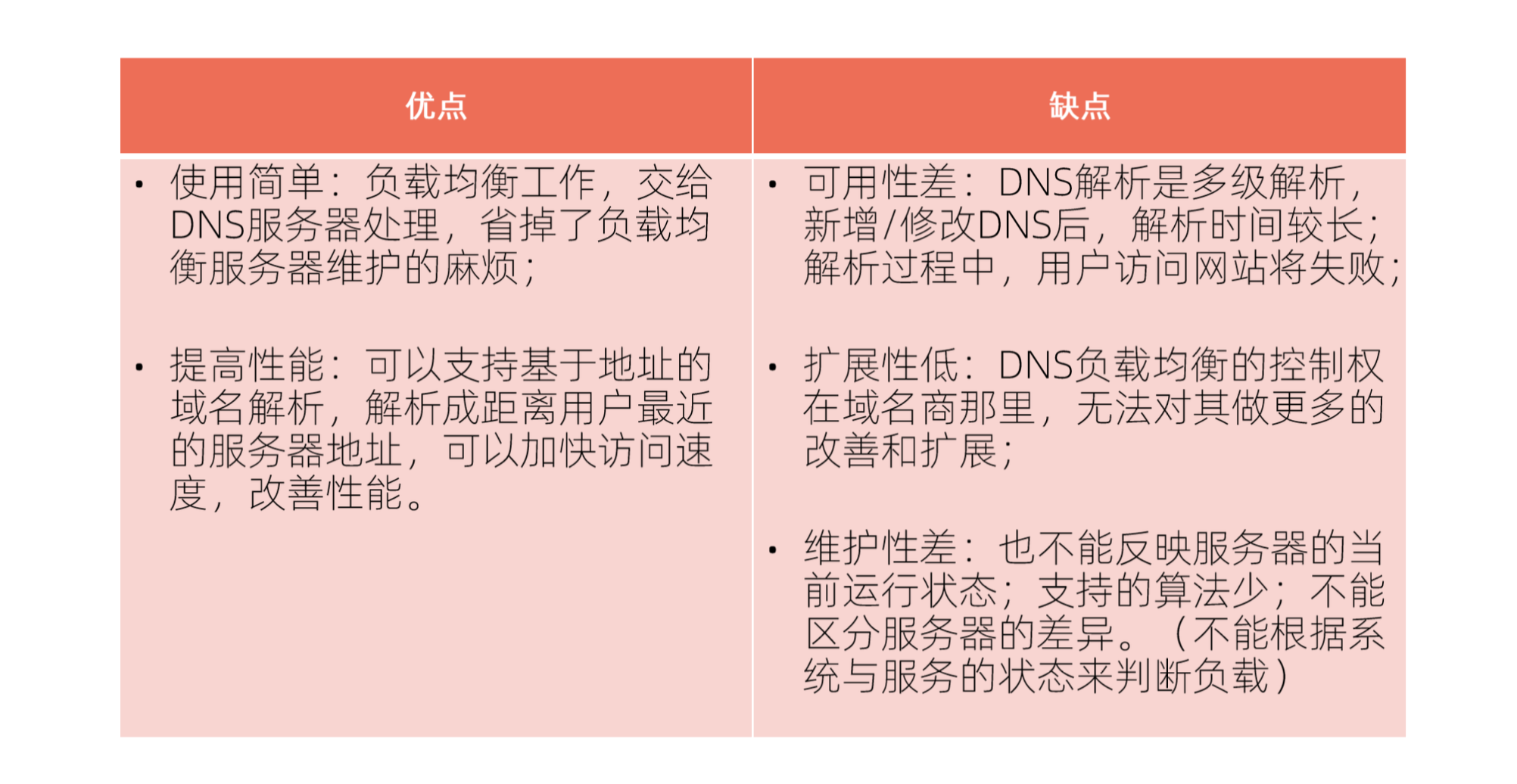

1. DNS 负载均衡

- 原理:在 DNS 服务器上为一个域名配置多个 A 记录,指向不同的服务器 IP。DNS 服务器在响应查询时,返回其中一个或多个 IP(通常基于轮询)。

- 优点:实现简单,全局负载均衡。

- 缺点:

- 生效慢:DNS 缓存导致 IP 变更传播延迟。

- 无法感知后端健康:DNS 不知道后端服务器是否可用。

- 负载不均:简单的轮询可能导致负载分配不均匀。

- Kubernetes 关联:

- 外部流量入口的第一层负载均衡(如 Route 53 将流量分发到不同区域的 K8s 集群 LoadBalancer IP)。

- Headless Service 返回多个 Pod IP,客户端可以基于 DNS 结果做简单的负载均衡(但不推荐)。

2. 集中式 LB (对应 Service LoadBalancer/Ingress)

- 原理:所有客户端请求都先发送到一个中心化的负载均衡器(硬件 F5 或软件 Nginx/HAProxy/Envoy),由它将请求转发给后端服务实例。

- 优点:集中管理流量策略、安全策略、健康检查。客户端实现简单。

- 缺点:

- 单点瓶颈:LB 自身可能成为性能或可用性瓶颈(需要 LB 集群)。

- 额外跳数:增加网络延迟。

- Kubernetes 关联:

Service类型LoadBalancer使用云厂商的集中式 LB。Ingress控制器本质上是在集群内部署了一个集中式的 L7 LB。

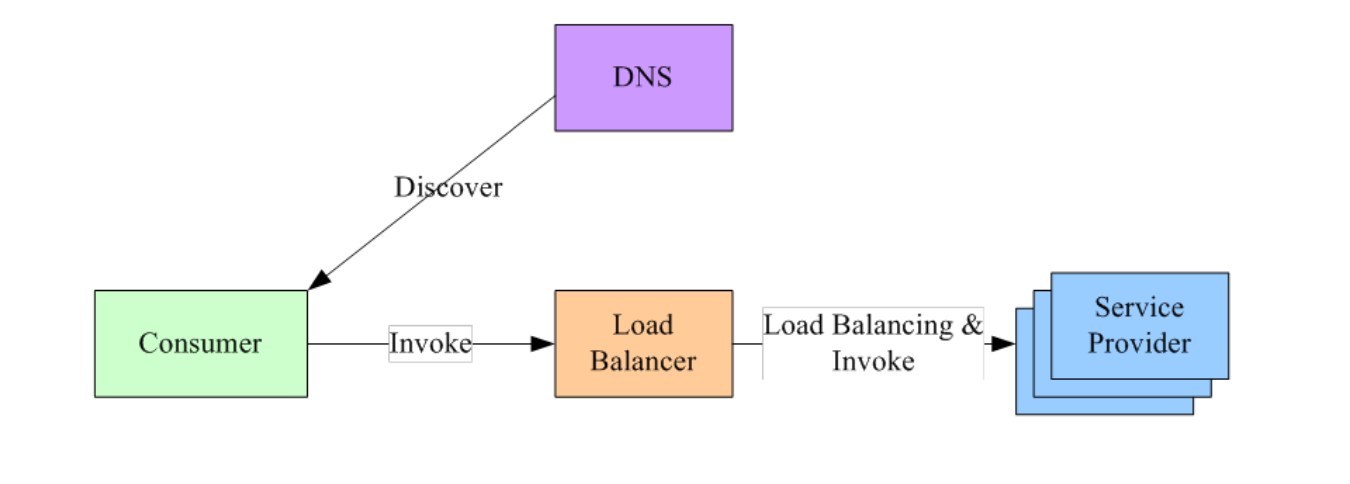

3. 客户端/进程内 LB (对应 Client Library 模式)

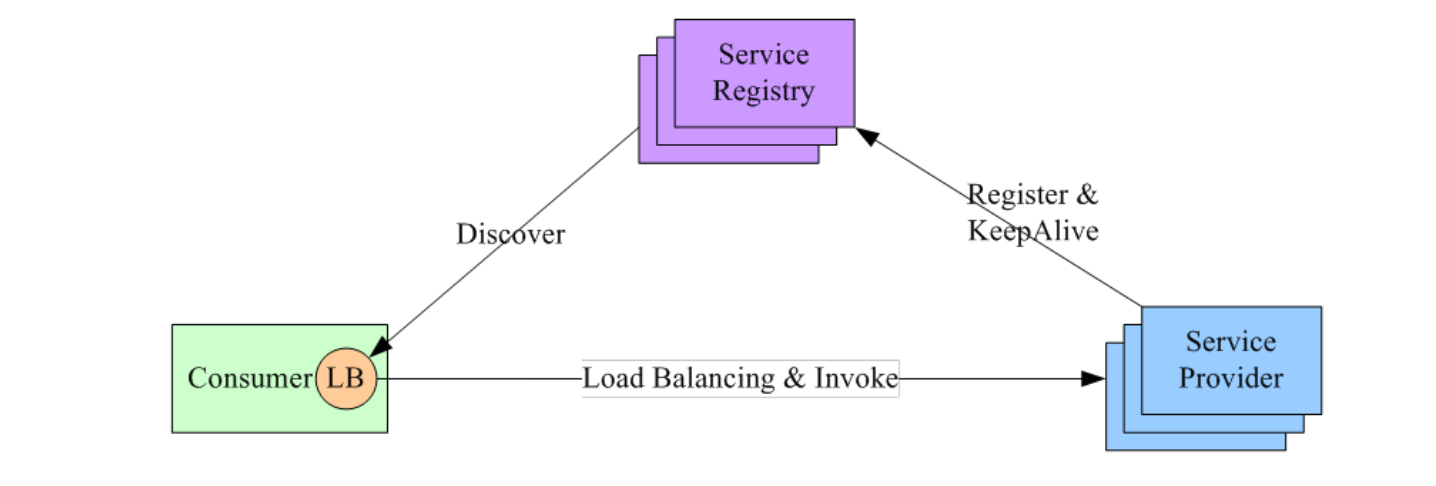

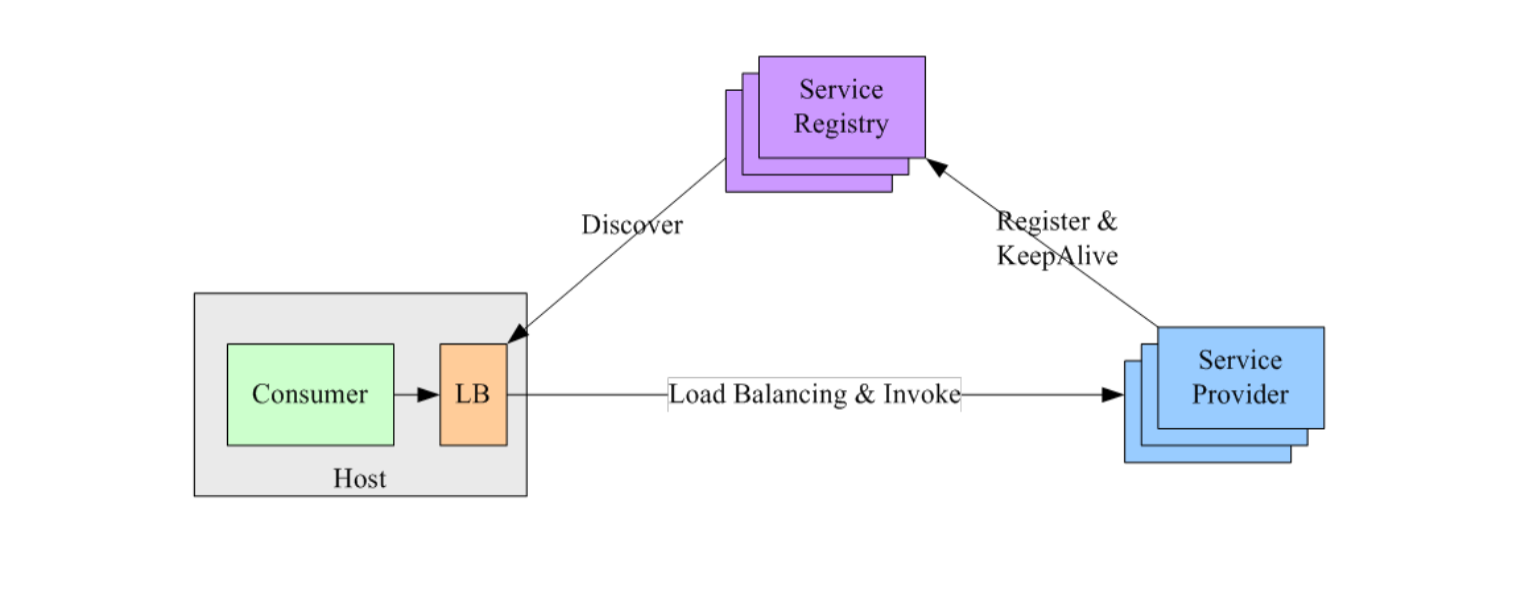

- 原理:负载均衡逻辑实现在客户端代码库中。客户端直接从服务注册中心(如 Consul, Etcd, Nacos 或 Kubernetes API Server)获取后端服务实例列表,并根据本地策略选择一个实例发起直接调用。

- 优点:

- 无额外跳数:性能好,延迟低。

- 去中心化:避免了集中式 LB 的单点瓶颈。

- 缺点:

- 客户端库耦合:需要在各种语言的客户端中实现或引入 LB 库(如 Ribbon, Spring Cloud LoadBalancer)。开发和维护成本高。

- 升级困难:LB 策略更新需要升级所有客户端。

- Kubernetes 关联:

- 客户端应用可以直接 Watch Kubernetes API 获取 Service Endpoints/EndpointSlices,然后在应用内部实现负载均衡。

- gRPC 等框架支持基于 Kubernetes 服务发现的客户端负载均衡。

4. Sidecar/独立进程 LB (对应 Service Mesh 模式)

- 原理:将负载均衡和网络通信逻辑从应用进程中剥离出来,放到一个独立的代理进程 (Sidecar) 中,该代理与应用容器一起部署在同一个 Pod 内。应用的所有出入流量都经过 Sidecar 代理。

- 优点:

- 应用无感知:负载均衡、服务发现、重试、熔断、遥测、安全等网络功能对应用透明。

- 语言无关:无需修改应用代码或引入特定库。

- 策略集中管理:通过控制面(如 Istio Pilot)统一配置和下发策略给所有 Sidecar。

- 缺点:

- 资源开销:每个 Pod 都需要运行一个 Sidecar 代理,增加资源消耗。

- 额外跳数 (本地):流量需要在应用容器和 Sidecar 容器之间通过本地网络栈转发,有微小延迟。

- 运维复杂度:引入了 Service Mesh 控制面和数据面,增加了系统的复杂性。

- Kubernetes 关联:

- Service Mesh (Istio, Linkerd) 是这种模式的典型实现。Sidecar (通常是 Envoy 或 linkerd-proxy) 拦截 Pod 流量,执行服务发现、负载均衡和各种流量策略。

其他相关技术 (LVS/NAT, LVS/DR, LVS/TUN)

这些是 Linux Virtual Server (LVS) 实现负载均衡的具体技术模式,主要用于构建高性能的 L4 负载均衡器。

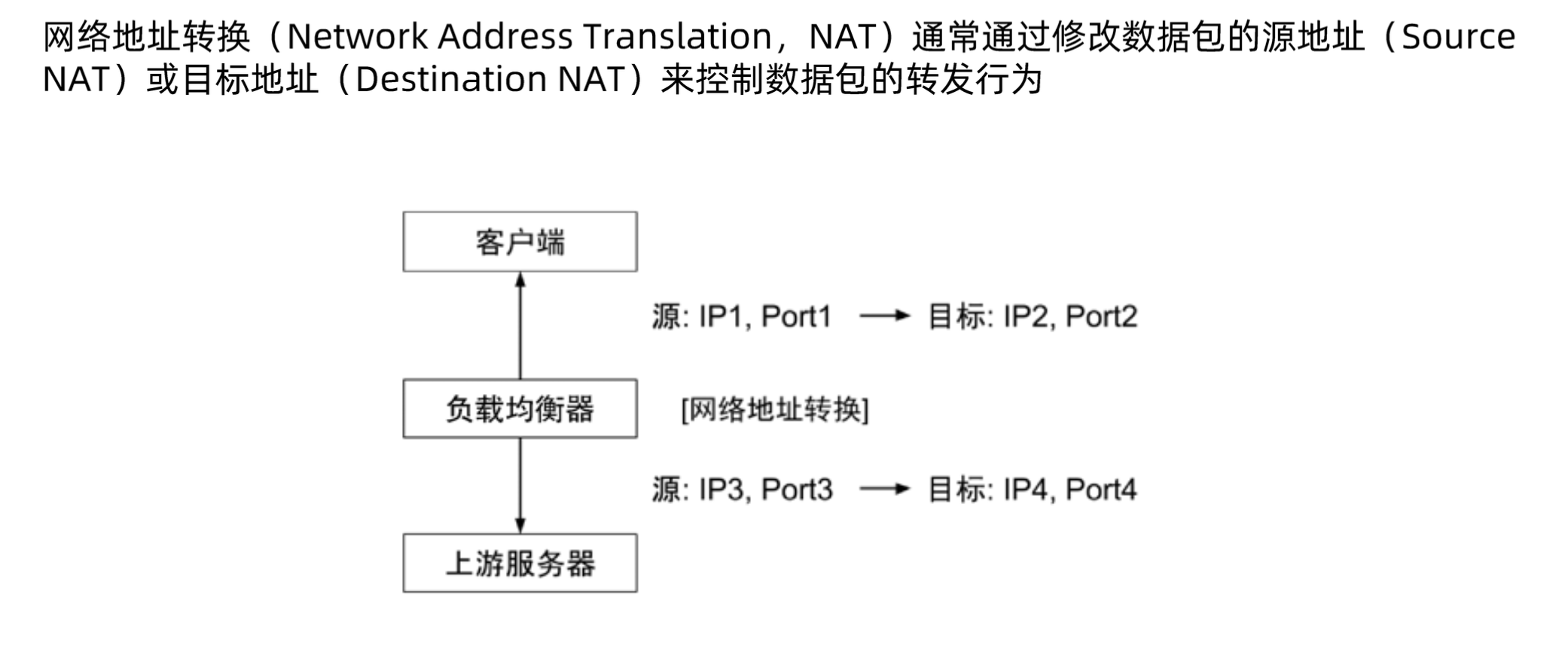

- NAT (Network Address Translation):

- 原理:LB 修改请求报文的目标 IP (改为后端服务器 IP),并将响应报文的源 IP (改回 LB 的 VIP)。进出流量都经过 LB。

- 缺点:LB 成为网络瓶颈。

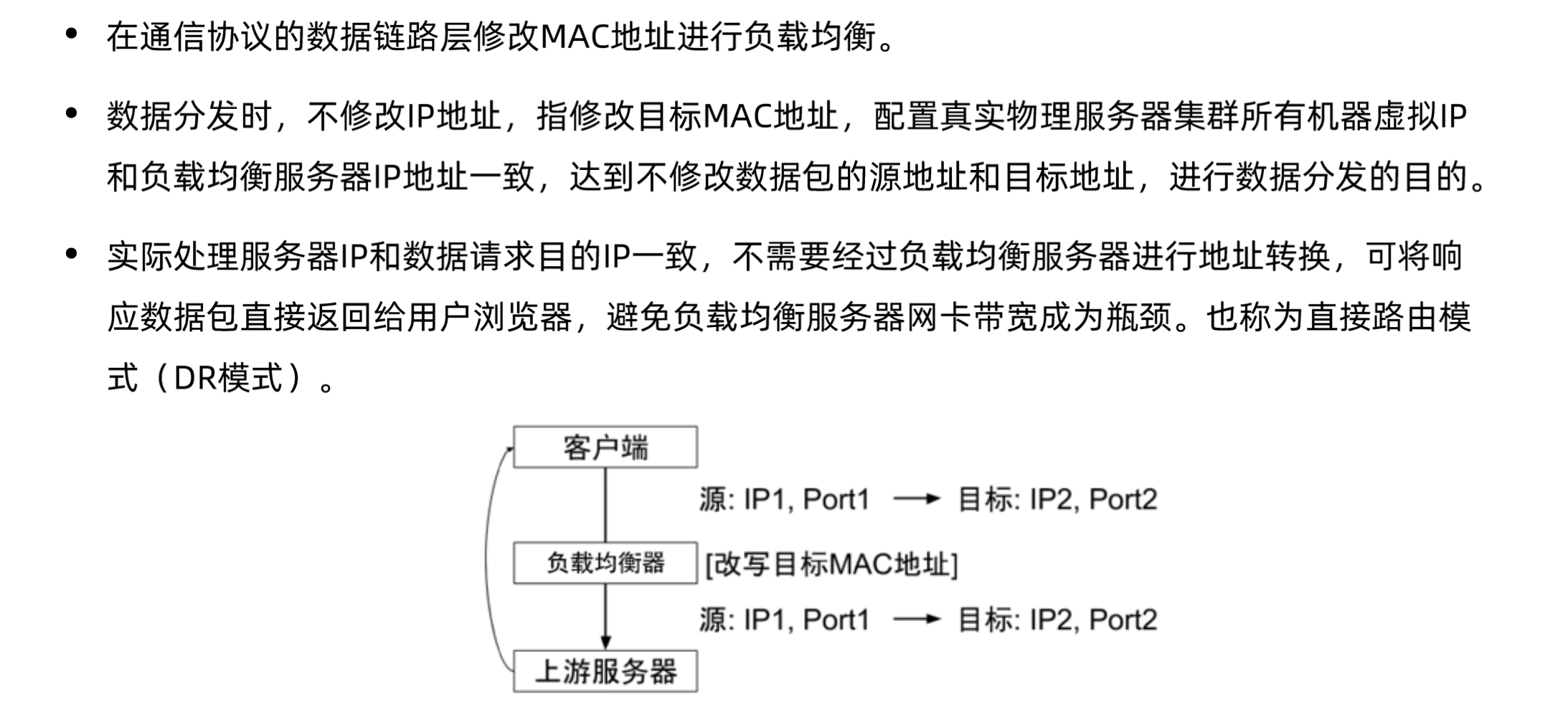

- DR (Direct Routing):

- 原理:LB 修改请求报文的目标 MAC 地址 (改为后端服务器 MAC),IP 地址不变。后端服务器直接将响应报文返回给客户端(不经过 LB)。

- 优点:性能高,LB 只处理入向流量。

- 要求:LB 和后端服务器在同一个 L2 网络。后端服务器需要配置 VIP 在 non-arp 网卡上。

- Kubernetes 关联:一些基于 LVS 的 K8s 网络方案或外部 LB 可能使用 DR 模式。kube-proxy 的 IPVS 模式底层利用了类似的技术。

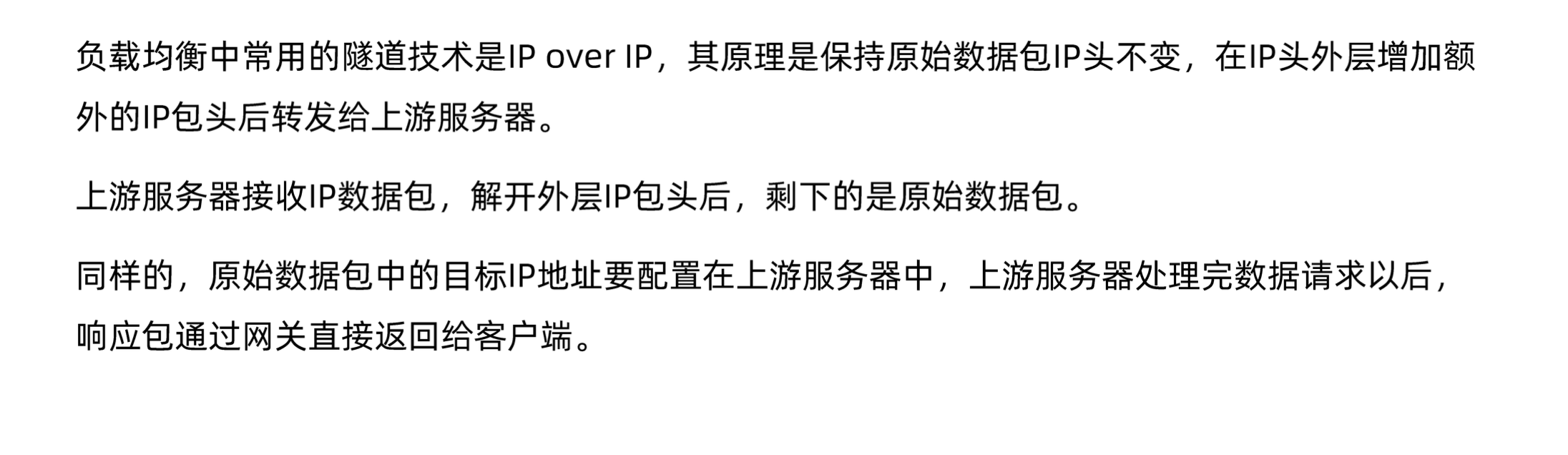

- TUN (Tunneling):

- 原理:LB 将原始请求报文封装在一个新的 IP 报文中(IP Tunneling),发给后端服务器。后端服务器解包处理后,直接响应给客户端。

- 优点:支持后端服务器不在同一 L2 网络。

- 缺点:有隧道封装开销。

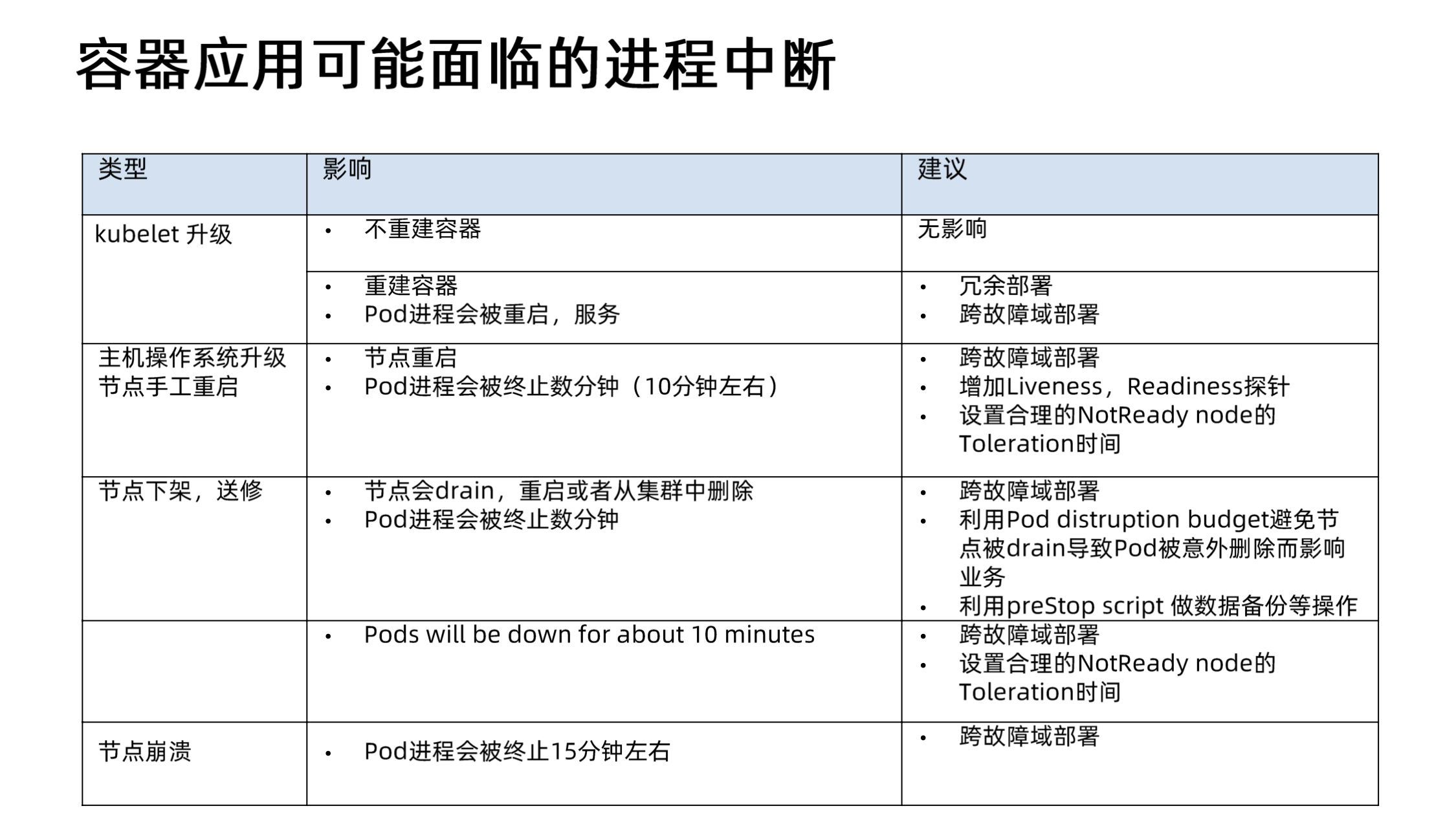

五、应对节点与进程中断

Kubernetes 环境是动态的,节点维护、升级、故障或资源压力都可能导致 Pod 被中断。需要采取策略来最小化这些中断对应用可用性的影响。

5.1 常见中断场景

- 节点维护 (Drain):管理员主动排空节点上的 Pod 以进行维护(如内核升级、硬件更换)。Pod 会被优雅地驱逐。

- 集群升级:升级 Kubernetes 控制面或节点组件 (kubelet, kube-proxy) 可能需要重启节点或 Pod。

- 节点资源压力:节点 CPU、内存、磁盘或 PID 资源耗尽,Kubelet 会驱逐 Pod 以回收资源(遵循 QoS 优先级)。

- 节点故障 (NotReady/Unknown):节点因硬件故障、网络分区或 Kubelet 崩溃而失联。控制器(如 node-controller)会在一段时间后(默认 5 分钟)将节点上的 Pod 标记为

Unknown或Terminating状态,并可能在其他节点上重建这些 Pod(取决于控制器类型,如 Deployment 会重建,StatefulSet 需要特殊处理)。 - Pod 自身故障:应用 Bug 导致 Liveness Probe 失败,容器被 Kubelet 重启。

- 抢占 (Preemption):更高优先级的 Pod 需要资源时,可能会抢占节点上低优先级的 Pod。

5.2 缓解策略

- 冗余部署 (Replicas):运行多个应用副本,是高可用的基础。

- 跨故障域部署 (Anti-Affinity, Topology Spread Constraints):将副本分散到不同节点、可用区、地域,降低单点故障影响。

- PodDisruptionBudget (PDB):限制自愿性中断期间同时不可用的 Pod 数量,保证最低服务水平。

- 优雅终止 (TerminationGracePeriodSeconds, preStop Hook):确保 Pod 在被终止前有时间完成清理工作,保存状态。

- 健康探针 (Readiness Probe):确保流量只发送到健康的、准备就绪的 Pod。

- 资源请求与限制 (Requests & Limits):合理配置资源,设置合适的 QoS 类,减少因资源不足被驱逐的风险。

- 优先级与抢占 (PriorityClass):为关键应用设置更高的优先级,使其不容易被抢占,并在资源不足时优先获得调度。

- 节点容忍度 (Tolerations):为 Pod 配置对节点污点 (Taints) 的容忍,例如容忍

NotReady或Unreachable状态一段时间,避免因短暂的网络抖动导致 Pod 被过早驱逐。

六、总结

Kubernetes 提供了强大的 Pod 生命周期管理和灵活的服务发现机制。通过深入理解 QoS、健康探针、Lifecycle Hooks、优雅终止、Service、Ingress、DNS 以及各种负载均衡模式,并结合高可用部署策略(如多副本、PDB、跨域部署),可以构建出稳定、可靠、可扩展的云原生应用。掌握这些核心概念对于在 Kubernetes 环境中成功部署和运维应用至关重要。